Forjando el Futuro: Ética y Liderazgo en la Revolución de la Inteligencia Artificial

Por Martin Francolino

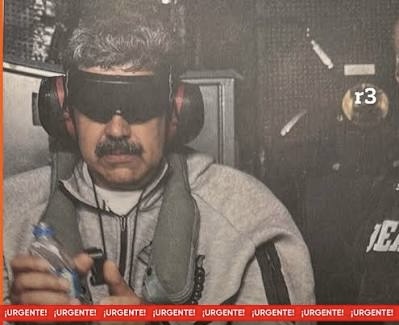

Hoy tuve el privilegio de ser invitado a la exposicion de «Ai In LatAm 2024» edición argentina, como resultado, quiero compartir con ustedes mi opinion profesional sobre la inteligencia artificial y su desarrollo en la empresas y el mundo del derecho y la justicia. En estos tiempos donde la inteligencia artificial se ha convertido en un eje central del debate global, es crucial reflexionar sobre cómo esta tecnología está remodelando el panorama empresarial y legal. No se trata simplemente de otro avance tecnológico, sino de una revolución que promete cambiar las estructuras fundamentales de cómo operan las empresas y el sistema judicial.

Desde mi perspectiva, la adopción de la inteligencia artificial por parte de las empresas no es solo inevitable, sino necesaria. Sin embargo, este entusiasmo por integrar la IA en cada rincón del mundo corporativo debe estar acompañado de un profundo entendimiento de los desafíos éticos y legales que implica. Es decir, no podemos permitir que esta revolución tecnológica vaya desencadenando caos sin antes establecer ciertos marcos de referencia que garanticen un uso responsable y ético.

Empecemos con el ámbito legal. Los abogados de hoy deben reconfigurarse para poder operar eficientemente en este nuevo ecosistema. La IA tiene la capacidad de transformar profesiones completas, y el ámbito legal no es una excepción. Las herramientas basadas en IA pueden procesar grandes volúmenes de datos legales a una velocidad que hace poco tiempo hubiese parecido inimaginable. Esto no solo permite a los abogados ofrecer servicios más precisos y rápidos, sino que también plantea inevitablemente la pregunta de qué sucederá con aquellos roles tradicionalmente considerados inmunes a la automatización.

Mientras, los jueces también enfrentan un cambio sin precedentes en su trabajo. La capacidad de la IA para analizar precedentes y agilizar el proceso de adjudicación es notable. Sin embargo, aquí es donde debemos ser cautelosos. A pesar de las ventajas, resulta esencial que los jueces mantengan la discrecionalidad en la toma de decisiones. El valor humano en los juicios reside precisamente en su capacidad para considerar matices y contextos que una máquina, por avanzada que sea, podría no captar del todo.

Al observar el terreno de las regulaciones, es evidente que la seguridad en el uso de la IA debe ser primordial. En Europa, la legislación ha avanzado significativamente bajo el amparo de la Ley de Inteligencia Artificial, que establece directrices claras para el desarrollo y uso de estas tecnologías. Este marco normativo, si bien riguroso, intenta asegurar que los avances no se realicen a expensas de derechos fundamentales ni de la seguridad de los ciudadanos.

Por otro lado, la visión de los Estados Unidos diverge significativamente. Con una política más abierta y flexible, Estados Unidos ha optado por fomentar la innovación a través de una estrategia de autoregulación y un enfoque de ‘esperar y ver’, conocido en la jerga como «wait and see». Esto impulsa la industria tecnológica, permitiendo que florezca sin restricciones pesadas, pero conlleva sus propios riesgos, ya que las garantías de seguridad y ética pueden quedar en un segundo plano si no se gestionan adecuadamente.

Entonces, ¿qué deben hacer las empresas para no perderse en este mar de oportunidades y desafíos? Primero, es fundamental que integren un profundo sentido de responsabilidad en su estrategia. Hay que considerar la implementación de comités internos de ética que supervisen el desarrollo y despliegue de la IA, asegurando que se respeten los estándares éticos y legales vigentes. Las empresas no pueden permitirse ignorar la importancia de la transparencia y la explicabilidad en sus sistemas de IA. En pocas palabras, cada algoritmo, cada proceso debe ser comprensible para todos los involucrados.

Además, deben desarrollar una estrategia integral que considere el ciclo de vida completo de la IA. No basta con crear e implementar; hay que evaluar y ajustar constantemente. Y no solo para cumplir con las regulaciones, sino para mitigar riesgos y evitar crisis que podrían haberse prevenido con una planificación adecuada.

Este camino hacia la innovación responsable también pasa por asegurar la privacidad y la protección de datos personales. Es vital que las empresas no solo cumplan con las leyes de protección de datos, sino que vayan más allá para establecer estándares de privacidad que generen confianza en sus consumidores.

El panorama es complejo y desafiante, no cabe duda. Pero en este mundo de IA, donde las fronteras de lo posible se expanden día a día, la responsabilidad y ética serán los verdaderos diferenciadores. Las organizaciones que logren integrar estos valores en el ADN de sus operaciones no solo se destacarán, sino que probablemente liderarán esta nueva era. Así, mientras el liderazgo en tecnología es algo a lo que todos aspiran, es el liderazgo en integridad lo que marcará la diferencia a largo plazo.

En definitiva, estamos en el umbral de una era donde la inteligencia artificial será un motor de cambio imparable, y estar preparados es más que un lujo: es una necesidad imprescindible. Las empresas y los profesionales del derecho deben alinear su rumbo hacia una coexistencia equilibrada con esta tecnología, garantizando que los beneficios no solo sean para unos pocos, sino que contribuyan al bienestar común, salvaguardando los principios que nos definen como sociedad.

Para ayudar al lector a comprender mejor los conceptos expuestos en el texto, se pueden incluir ejemplos concretos que ilustren cómo la inteligencia artificial (IA) está impactando diferentes sectores y las implicaciones éticas y legales que esto conlleva.

Imaginemos un despacho de abogados que implementa un sistema de inteligencia artificial para la revisión de documentos. En lugar de que los abogados dediquen horas a revisar contratos y documentos legales extensos, la IA puede realizar un análisis preliminar en minutos, identificando cláusulas clave y posibles riesgos. Esto no solo aumenta la eficiencia, sino que también permite a los abogados enfocarse en tareas más estratégicas, como asesorar a sus clientes en decisiones críticas. Sin embargo, este avance plantea un dilema ético: ¿qué sucede si la IA comete un error en la interpretación de una cláusula? La responsabilidad recae sobre el abogado que confió en la herramienta, lo que resalta la importancia de la supervisión profesional y la necesidad de establecer protocolos claros.

Otro ejemplo se puede ver en cómo la IA está transformando el sistema judicial. En algunos países, se han desarrollado sistemas de predicción de sentencias que analizan datos históricos sobre casos similares para ofrecer recomendaciones sobre la posible duración de una pena o la probabilidad de apelaciones. Este uso de la IA puede agilizar procesos y ofrecer mayor consistencia en las decisiones judiciales. Sin embargo, aquí entra en juego la cuestión de la equidad. Si el sistema de IA se basa en datos históricos que reflejan sesgos raciales o socioeconómicos, entonces las recomendaciones pueden perpetuar estos prejuicios, lo que desafía la noción de justicia imparcial.

En el ámbito regulatorio, un ejemplo claro es la Ley de Inteligencia Artificial en Europa. Esta legislación busca proteger a los ciudadanos estableciendo estándares claros sobre cómo las empresas deben diseñar y utilizar sistemas de IA. Por ejemplo, una compañía de vehículos autónomos debe cumplir con pruebas rigurosas de seguridad antes de que sus automóviles puedan ser comercializados. Aquí se observa la necesidad de que las regulaciones mantengan el paso con la innovación tecnológica para garantizar que el progreso no se realice a costa de la seguridad pública.

Haciendo hincapié en la privacidad de datos, pensemos en una aplicación de salud que utiliza IA para ofrecer recomendaciones personalizadas a los usuarios. Si la app recopila información sensible sobre la salud de los usuarios, es fundamental que la empresa no solo cumpla con las leyes de protección de datos, sino que también implemente medidas que refuercen la confianza. Por ejemplo, proporcionar al usuario la opción de decidir cómo se utiliza su información y quién tiene acceso a ella no solo es un requisito legal en muchas jurisdicciones, sino que también es una práctica ética que fortalece la relación con el cliente.

Por último, en términos de crear una cultura de responsabilidad y ética en las empresas, se puede mencionar a compañías como Google, que han establecido comités de ética en IA para revisar los proyectos y asegurarse de que respeten principios fundamentales como la equidad, la transparencia y la seguridad. Este enfoque demuestra que las empresas no solo buscan innovar, sino que también están comprometidas en hacerlo de manera que beneficie a la sociedad en su conjunto.

Estos ejemplos ilustran cómo la IA está cambiando no solo la forma en que se hacen los negocios, sino también cómo interactuamos con la ley y cómo vivimos nuestras vidas. Al comprender estos impactos, pueden apreciar mejor la urgencia de abordar los desafíos éticos y legales que plantea esta tecnología transformadora.